如何定义CNN的超参数 答:尽量不要自己设置超参数,而是查看文献中别人采用了哪些超参数。以前是一些经典的模型。

Input层和Pool层没有参数,大部分参数在FC层。

Activation Size越来越小,如果下降太快可能会影响网络性能。

1. LeNet-5

论文:LeGun et at., 1998. Gradient-based learning applies to document recognition section II

- W减小,H减小,C增大。

- CONV -> POOL -> CONV -> POOL -> FC -> FC -> output,经典结构

- 使用sigmoid/tanh --- 废弃

- 使用复杂的计算来处理POOL中的通道 --- 当时性能限制,废弃

- 池化使用了非线性函数 --- 废弃

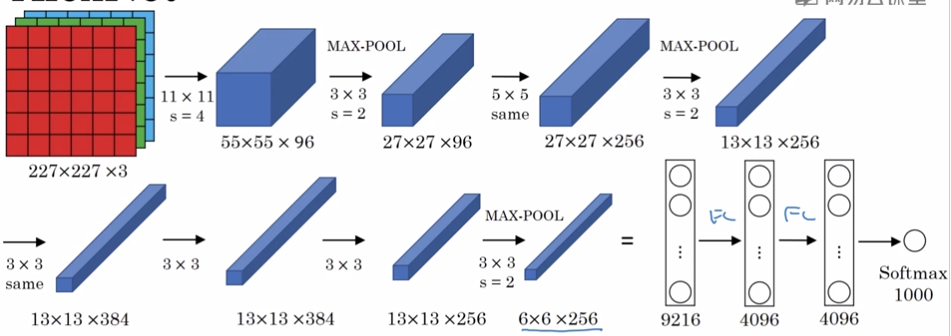

2. AlexNet

论文:Krizhevsky et al., 2012. Image Net classification with deep convolutional neural networks

- 特征数量大。

- 能处理非常相似的基本模型。

- 使用ReLU

- 多GPU

- 局部响应归一化 --- 不常用

3. VGG- 16

- 相对一致的结构

- 特征数量非常大